목록GCP/Qwiklabs (54)

JINIers

Google Cloud HA VPN 구성하기

Google Cloud HA VPN 구성하기

관련퀵랩 개요 vpc 2개 생성 방화벽 규칙 생성 vpn gw 생성 bgp 피어링 생성 vpn 터널 확인 목표 2개의 vpc 네트워크와 인스턴스 생성 HA VPN 게이트웨이 구성 VPN 터널로 동적 라우팅 구성 전역 동적 라우팅 모드 구성 HA VPN gw 구성 확인 및 테스트 생각보다 어렵다. 잘 따라해보자. 작업1. 전역 vpc 환경설정 [vpc 설정] # demo vpc 생성 gcloud compute networks create [vpc명] --subnet-mode custom gcloud compute networks create vpc-demo --subnet-mode custom # demo vpc subnet 생성(us-central1) gcloud compute networks subne..

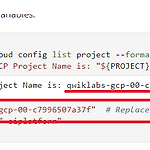

Terraform을 사용하여 Google Cloud에서 인프라 자동화: Challenge Lab test 주제 기존 인프라를 terraform 구성으로 가져오기 terraform 모듈 빌드 및 참조 구성에 원격 백엔드 추가 terraform 레지스트리의 모듈 사용 및 구현 인프라 재프로비저닝, 파괴 및 업데이트 생성한 리소스 간의 연결 테스트 참고 동영상 : https://youtu.be/eY7pYGX2MTo 작업 1. 구성파일 생성 아래의 파일 및 디렉토리를 touch, mkdir 이용 생성 main.tf variables.tf modules/ └── instances ├── instances.tf ├── outputs.tf └── variables.tf └── storage ├── storage.tf..

220901_Interact with Terraform Modules

220901_Interact with Terraform Modules

Terraform 모듈과 상호 작용 [개요] terrform으로 인프라를 관리하면 복잡한 구성이 생성됨 그럴 때 발생하는 문제 1. 구성파일을 이해하고 탐색하기 어려움 2. 한 블록을 업데이트 하면 구성의 다른 블록에 의도하지 않은 결과가 발생할 수 있으므로 구성 업데이트는 더 위험해짐 3. 프로젝트와 팀 간에 구성의 일부를 공유하려는 경우 프로젝트 간 구성블록을 복붙하는 것은 오류가 발생하기 쉽고 유지 관리하기 어려울 수 있음 ▶ 모듈을 사용하면 위의 문제들을 해결할 수 있음 - Organize configuration 구성의 관련부분을 함께 유지하여 구성을 보다 쉽개 탐색, 이해 및 업데이트 할 수 있다. 모듈을 사용하여 구성을 논리적 수엉요소로 구성할 수 있음 - Encapsulate configu..

220831_Infrastructure as Code with Terraform

220831_Infrastructure as Code with Terraform

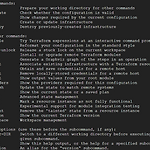

Terraform을 사용한 코드형 인프라 + 수정 : 220901: 부가설명 추가 [개요] terraform - 코드로서의 인프라 - 안전하고 반복 가능한 방식 - 인프라 구축, 변경, 관리하기 위한 도구 - HCL(HashiCorp Configuration Language) 이라는 구성언어로 환경을 관리할 수 있음 사용자 인터페이스에서 리소스를 수동으로 구성하는 대신 파일에서 인프라를 관리하는 프로세스 운영자가 HCL를 사용하여 원하는 리소스의 정의가 포함된 파일을 작성할 수 있음 [워크플로] - 범위 : 주어진 프로젝트에 대해 생성해야하는 리소스 확인 - 작성자 : 범위 매게변수를 기반으로 HCL에서 구성파일 생성 - 초기화 : terraform init ㄴ 구성파일이 있는 프로젝트 디렉토리에서 실행..

220830_Terraform Fundamentals

220830_Terraform Fundamentals

220830_Terraform Fundamentals [개요] terraform 시작 설치 바이너리에서 terraform을 설치 terraform을 사용하여 vm 인스턴스 인프라를 구축 [테라폼이란?] 인프라를 안전하고 효율적으로 구축,변경 및 버전을 관리하기 위한 도구 기존의 인기있는 서비스 제공업체와 맞춤형 사내 솔루션을 관리할 수 있음 구성파일 : 단일 애플리에키션 or 전체 데이터 센터를 실행하는데 필요한 구성요소 원하는 상태에 도달하기 위해 수행할 작업을 설명하는 실행 계획을 생성한 다음 이를 실행ㅎ여 설명된 인프라 구축 terraform이 관리할 수 있는 인프라 - 컴퓨팅 인스턴스, 스토리지 및 네트워킹과 같은 하위 수준 구성 요소 - DNS 항목 및 SaaS 기능과 같은 상위 수준 구성요소 ..

220704_Kubernetes Engine: Qwik Start

220704_Kubernetes Engine: Qwik Start

220704_Kubernetes Engine: Qwik Start GKE : Google Kubernetes Engine google 인프라를 사용하여 컨테이너화된 애플리케이션을 배포, 관리 및 확장하기 위한 관리형 환경을 제공 GKE를 사용하여 컨테이너 생성 및 애플리케이션을 배포할 수 있음 GKE cluster kubernetes 오픈소스 클러스터 관리 시스템을 기반으로 함 컨테이너 클러스터와 상호 작용하는 메커니즘 제공 명령 및 리소스를 사용하여 애플리케이션을 배포,관리 관리작업 수행, 정책설정, 배포된 워크로드의 상태를 모니터링함 작업1. 기본 컴퓨팅 영역 설정 gcloud config set compute/zone us-central1-a 작업2. GKE 클러스터 만들기 # 클러스터 생성 gcl..

220630_Introduction to Docker

220630_Introduction to Docker

220630_Introduction to Docker 도커 소개 [개요] Docker 애플리케이션 개발, 배송 및 실행하기 위한 개방형 플랫폼 도커를 사용하면 인프라에서 애플리케이션을 분리하고 인프라를 관리되는 애플리케이션처럼 취급할 수 있음 커널 컨테이너화 기능을 애플리케이션 관리 및 배포에 도움이 되는 워크플로 및 도구와 결합하여 수행함 Docker container는 Kubernetes에서 직접 사용할 수 있으므로 Kubernetes Engine에서 쉽게 실행 할 수 있음 [중점사항] Docker 컨테이너를 빌드, 실행 및 디버그 하는 방법 Docker hub 및 google container registry에서 docker 이미지를 가져오는 법 Docker 이미지를 google container ..

220608_Loading Taxi Data into Google Cloud SQL 2.5

220608_Loading Taxi Data into Google Cloud SQL 2.5

택시 데이터를 Google Cloud SQL 2.5로 로드하기 [개요] CSV 텍스트 파일에서 Cloud SQL로 데이터를 가져온 뒤, 단순 쿼리를 사용하여 기본 데이터 분석을 수행 [목표] Cloud SQL 인스턴스 만들기 Cloud SQL 데이터베이스 만들기 Cloud SQL 텍스트 데이터 가져오기 데이터 무결성 확인하기 0. 환경준비 [환경변수와 데이터를 저장할 저장용량 버킷 생성] export PROJECT_ID=$(gcloud info --format='value(config.project)') export BUCKET=${PROJECT_ID}-ml 1. Cloud SQL 인스턴스 만들기 [Cloud SQL 인스턴스 생성] gcloud sql instances create taxi \ --tie..

220609_Loading data into BigQuery

220609_Loading data into BigQuery

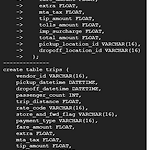

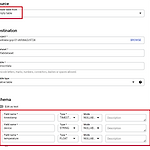

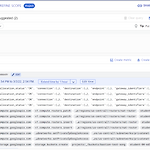

BigQuery에 데이터 로드하기 BigQuery : google의 완전관리형, NoOps, 저비용분석 데이터베이스 [학습내용] 1. 다양한 소스에서 BigQuery에 데이터 로드하기 2. CLI 및 콘솔을 사용하여 BigQuery에 데이터 로드하기 3. DDL을 사용하여 테이블 만들기 1. 테이블을 저장하기 위해 새 데이터세트 만들기 bigquery > create dataset > name : nyctaxi > create 2. CSV에서 새 데이터세트 수집 create table > create Create table from: Upload Choose File: select the file you downloaded locally earlier File format: CSV name : 2018t..

220607_Using BigQuery to do Analysis

220607_Using BigQuery to do Analysis

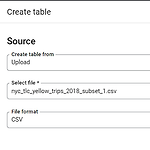

BigQuery를 사용하여 분석하기 [학습내용] bigquery 콘솔에서 대화형 쿼리 수행 다양한 데이터세트를 조합하여 분석을 실행 1. 자전거 대여 데이터 살펴보기 bigquery > add data > explore public datasets > 'NYC bike' 검색 > view datasets * 테이블에 뜨지 않으면 pin a project > enter project name > project name 입력 bigquery-public-data > new_york_citibike > citibike_trips 선택 # 쿼리 입력 SELECT MIN(start_station_name) AS start_station_name, MIN(end_station_name) AS end_station_..

220603_Cloud Functions: Qwik Start - 콘솔 [개요] cloud functions 클라우드 서비스를 구축하고 연결하기 위한 서버리스 실행환경 cloud functions을 사용하면 클라우드 인프라 및 서비스에서 발생하는 이벤트에 연결된 간단한 단일 목적 함수 작성 가능 감시 중인 이벤트가 발생하면 cloud 함수 트리거 코드 : 완전 관리형 환경에서 실행 자바스크립트로 작성되며 Node.js환경에서 실행됨 클라우드 서비스를 연결하고 확장하는 코드를 작성할 수 있는 연결 논리계층 제공 google 서비스 계정 사용자 인증 정보에 액세스 할 수 있으므로 datastore, cloud spanner, cloud translation api 등의 여러 클라우드 서비스에서 원활하게 인증..

220524_BigQuery in JupyterLab on Vertex AI 2.5

220524_BigQuery in JupyterLab on Vertex AI 2.5

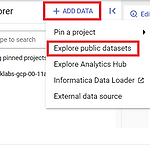

개요 vertex ai에서 jupyter 노트북 인스턴스화 jupyter 노트북 내에서 bigquery 쿼리를 실행하고 pandas를 사용하여 출력 처리 작업 1. jupyterLab 노트북 인스턴스 시작 vertex ai > workbench > user-managed notebooks > new notebooks > python3 > create > jupyterlab 열기 작업 2. bigquery 쿼리실행 [1] google cloud 모듈설치 !pip install google-cloud-bigquery==1.25.0 --use-feature=2020-resolver 실행 후 restart kernel > restart [2] 마술기능 사용 쿼리 %%bigquery df # %%bigquery ..

개요 vertex ai 노트북 실행 bigquery 쿼리 호출 jupyter에서 차트 만들기 기계 학습을 위한 데이터 내보내기 작업 1. bigquery 호출 bigquery > 쿼리편집기 # 00 ~ 05년 사이에 미국에서 태어난 세쌍둥이 찾기 SELECT plurality, COUNT(1) AS num_babies, AVG(weight_pounds) AS ave_weight FROM `bigquery-public-data.samples.natality` WHERE year > 2000 AND year workbench > new notebook > python3 > create region :..

220520_Vertex AI Platform: Qwik Start

220520_Vertex AI Platform: Qwik Start

220520_Vertex AI Platform: Qwik Start [개요] 1. tensorflow 모델 학습 및 모델 Vertex AI Platform에 배포하여 제공 2. 미국 인구조사 소득 데이터 세트를 이용하여 개인의 소득 범주를 예측하는 모델을 훈련함 [수행내용] 1. tensorflow 교육 애플리케이션을 만들고 로컬에서 검증 2. 클라우드의 단일 작업자 인스턴스에서 교육 작업 실행 3. 예측을 지원하는 모델 배포 4. 온라인 예측 요청 및 응답 확인 작업 1. vertex AI Platform 노트북 출시 vertex ai > workbench > new notebooks > tensorflow 2.8 Without GPU 선택 > create 작업 2. vertex AI Platform ..

220510_Streaming IoT Data to Cloud Storage

220510_Streaming IoT Data to Cloud Storage

220510_Streaming IoT Data to Cloud Storage IoT 데이터를 Cloud Storage로 스트리밍 개요 cloud iot core 및 cloud pub/sub 구성하여 디바이스에서 스트리밍 데이터 수집 목표 1. cloud pub/sub 주제 및 구독 만들기 2. iot core를 사용하여 레지스트리 만들기 3. 시뮬레이터에서 MQTT 애플리케이션 시작 4. cloud storage로 데이터 스트리밍 1. cloud pub/sub 설정 및 주제 pub/sub > topic > create topic topic id : iotlab 2. 주제권한 설정 add principal > topic member : cloud-iot@system.gserviceaccount.com ro..

Building and Deploying Machine Learning Solutions with Vertex AI: Challenge Lab

Building and Deploying Machine Learning Solutions with Vertex AI: Challenge Lab

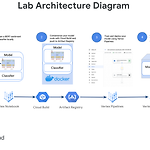

220427_vertex AI로 머신러닝 솔루션 구축 및 배포 시작하기 전에 이거 시간 진짜 오래걸리고 정말 어려움 퀵랩 기회는 5번인데 막판에 성공했다. 오타 하나라도 나면 에러나서 안되고 기존에 생성되어 있는 것 중에 알파벳 하나라도 지우면 그냥 그날로 끝임 종료하고 새로 시작해야함 ㅎ 진짜... 킹받아 시작하자.. 목표 1. 호스팅된 vertex 노트북에서 로컬로 tensorflow 모델을 훈련시킴 2. cloud build로 학습 코드를 컨테이너화하고 vertex 커스텀 컨테이너 학습 워크플로의 일부로 google cloud artifact registry에 푸시 3. 예측을 제공하기 위해 학습된 모델을 vertex on line prediction endpoint에 배포 4. 온라인 예측 요청 ..

Building an IoT Analytics Pipeline on Google Cloud

Building an IoT Analytics Pipeline on Google Cloud

※ 수정 220930 : 내용 수정 Google Cloud에서 IoT 분석 파이프라인 구축 구성요소 2가지 1. 장치관리자 : 서비스에 장치를 등록, 장리츨 모니터링하고 구성할 수 있다. 2. 프로토콜 브리지 : 기기가 google cloud에 연결하는 데 사용할 수 있는 MQTT를 지원 * MQTT : 메시지 큐잉 텔레메트리 트랜스포트, Message Queuing Telemetry Transport - IoT, M2M을 위한 프로토콜, 최소한의 전력과 패킷으로 통신하는 프로토콜 목표 Cloud IoT Core를 사용하여 MQTT 기반 장치 연결 및 관리(시뮬레이션된 장치 사용) Cloud Pub/Sub를 사용하여 Cloud IoT Core에서 정보 스트림을 수집합니다. Cloud Dataflow를 사..

Building and Deploying Machine Learning Solutions with Vertex AI: Challenge Lab

Building and Deploying Machine Learning Solutions with Vertex AI: Challenge Lab

220427_vertex AI로 머신러닝 솔루션 구축 및 배포 테스트한 주제 1. 호스팅된 vertex 노트북에서 로컬로 tensorflow 모델을 훈련시킴 2. cloud build로 학습 코드를 컨테이너화하고 vertex 커스텀 컨테이너 학습 워크플로의 일부로 google cloud artifact registry에 푸시 3. 예측을 제공하기 위해 핛급된 모델을 vertex on line prediction endpoint에 배포 4. 온라인 예측 요청 및 응답확인 와 근데 이거 진짜 좀 어려워.. 5번 시도했는데 5번 다 실패했다. 퀵랩은 4~5번정도 하면 더이상 할 수 없다고 실습이 잠겨버리는데 그럴땐 문의를 해서 풀어달라고 요청하면된다. 내가 최대로 했을 때가 80점이었음 흑흑 도전 시나리오 제..

Vertex Pipelines: Qwik Start

Vertex Pipelines: Qwik Start

220426_Vertex Pipelines: Qwik Start 이거 좀 어려웠.. 양도 많고 코드도 하나하나 보려니 어렵고 힘들고 시간이 부족 ㅠㅜ 개 요 vertex pipelines을 이용하여 ML 파이프라인 생성 및 실행 ML 파이프라인이 유용한 이유 데이터 처리, 모델 교육, 초매개변수 조정, 평가 및 모델 배포가 포함된 ML 워크플로를 구축한다고 상상해 보십시오. 이러한 각 단계는 서로 다른 종속성을 가질 수 있으며 전체 워크플로를 단일체로 취급하면 다루기 어려워질 수 있습니다. ML 프로세스를 확장하기 시작할 때 팀의 다른 사람들과 ML 워크플로를 공유하여 다른 사람들이 실행하고 코드에 기여할 수 있도록 할 수 있습니다. 신뢰할 수 있고 재현 가능한 프로세스가 없으면 이 작업이 어려워질 수 ..

Deploy a BigQuery ML Customer Churn Classifier to Vertex AI for Online Predictions

Deploy a BigQuery ML Customer Churn Classifier to Vertex AI for Online Predictions

온라인 예측을 위해 big query ML 고객 이탈 분류기를 vertex ai에 배포 개요 bigquery ML XGBoost 모델을 사용하여 일괄 및 온라인 예측을 학습, 조정, 평가, 설명,생성함 사용자가 애플리케이션으로 돌아올 가능성 확인 bigquery ML 모델로 일괄예측 생성, vertex pyhton SDK를 사용하여 온라인 예측을 위해 vertex AI로 내보내고 배포 목표 기계학습용 bigquery에서 google 애널리틱스 4 데이터 샘플을 탐색하고 사전처리함 bigquery ML XGBoost 분류기를 학습시켜 모바일 게임 애플리케이션에서 사용자 이탈 예측 bigquery ML 초 매개변수 조정기능을 사용하여 bigquery ML XGBoost 분류기 조정 bigquery ML XG..

220425_Identify Damaged Car Parts with Vertex AutoML Vision

220425_Identify Damaged Car Parts with Vertex AutoML Vision

Vertex AutoML Vision으로 손상된 자동차 부품 식별 개요 autoML vision : ML 전문지식이 제한된 사람이라도 누구나 이미지 분류 모델을 훈련할 수 있도록 도와줌 ML 모델 생성 시 즉시 사용가능, UI or rest API 이용하여 google cloud console에서 직접 예측 생성 시작가능 목표 csv 파일을 사용하여 레이블이 지정된 데이터 세트를 cloud storage에 업로드하고 vertex ai에 관리 데이터세트로 연결 업로드된 이미지를 검사하여 데이터세트에 오류가 없는지 확인 학습된 모델을 검토하고 정확도 평가 1. cloud storage에 학습 이미지 업로드 [cloud storage 버킷 만들기] 환경변수 지정 export PROJECT_ID=$DEVSHEL..

Vertex AI: Qwik Start

Vertex AI: Qwik Start

220425_Vertex AI: Qwik Start 참고 : https://cloud.google.com/vertex-ai/docs/start/introduction-unified-platform vertex AI 공부 - vertex AI란 : 필요한 ML 도구를 포함한 하나의 AI 플랫폼 특징 1. 전체 ML 워크플로를 위한 통합 UI - 하나의 통합 UI 및 API로 ML을 빌드하기 위해 google cloud 서비스를 한 곳에 모은 것 2. 비전, 동영상, 자연어 등을 위한 선행 학습된 API 3. 데이터 및 AI를 위한 end to end 통합 - vertex AI Workbench를 통해 bigquery, dataproc, spark와 통합됨 - 표준 sql 쿼리 사용 bigquery에서 머신..

[Qwiklabs] Configuring Private Google Access and Cloud NAT

[Qwiklabs] Configuring Private Google Access and Cloud NAT

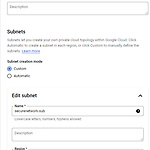

비공개 google 액세스 및 cloud nat 구성(VPC + NAT) [목표] 외부 ip 주소가 없는 vm 인스턴스 구성 외부 ip 주소가 없는 vm에 연결한 bastion host 생성 서브넷에서 비공개 google 액세스를 활성화 cloud nat 게이트웨이 구성 google api 및 서비스의 공개 ip 주소 및 기타 인터넷 연결에 대한 액세스 확인 cloud nat 로깅으로 nat 연결 기록 1. vm 인스턴스 만들기 [vpc 네트워크 및 방화벽 규칙 만들기] vpc network create - name : privatenet - subnet creation mode : custom - Name : privatenet-us - Region : us-central1 - IP address ra..

[Qwiklabs] Google Cloud Packet Mirroring with OpenSource IDS

[Qwiklabs] Google Cloud Packet Mirroring with OpenSource IDS

오픈 소스 IDS를 사용한 google cloud 패킷 미러링 트래픽 미러링 : 보안 및 네트워크 분석을 위한 google cloud 네트워킹의 핵심 기능 ※유의※ Packet Mirroring : 각 패킷의 전체 페이로드를 캡쳐하므로 추가 대역폭을 소비한다. 샘플링 주기를 기반으로 하지 않기 때문에 더 나은 문제해결, 보안 솔루션 및 상위계층 응용 프로그램 기반 분석에 사용할 수 있음 패킷 미러링 정책을 기반으로 한다. Region VPC Network(s) Mirrored Source(s) Collector (destination) Mirrored traffic (filter) 고려사항 TCP, UDP 및 ICMP 트래픽만 미러링 가능 Mirrored Source(s)와 Collector (desti..

Create an Internal Load Balancer

Create an Internal Load Balancer

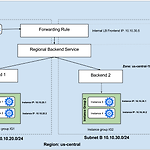

※ 수정 220930 : 내용 수정 내부 로드밸런서 생성 목표 http 및 상태 확인 방화벽 규칙 만들기 두 개의 인스턴스 템플릿 구성 관리형 인스턴스 그룹 2개 만들기 내부 부하 분산장치 구성 및 테스트 1. http 및 상태 확인 방화벽 규칙 구성 [my-internal-app 네트워크 탐색] vpc network > vpc network > my-internal-app 있는지 확인 [http 방화벽 규칙 만들기] gcloud compute firewall-rules create app-allow-http --direction=INGRESS --priority=1000 --network=my-internal-app --action=ALLOW --rules=tcp:80 --source-ranges=0...

[Qwiklabs] HTTP Load Balancer with Cloud Armor

[Qwiklabs] HTTP Load Balancer with Cloud Armor

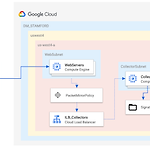

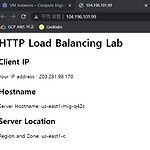

Cloud Armor가 포함된 http 부하분산기 cloud armor ip allow list / deny list를 사용하면 google cloud 엣지에서 사용자 및 악성 트래픽에 대해 최대한 가까운 http(s) 로드밸런서에 대한 액세스를 제한하거나 허용할 수 있음 → 이러면 악의적인 사용자나 트래픽이 리소스를 소비하거나 VPC 네트워크에 들어가는 것을 방지할 수 있음 이거라는데 어.... 그래요... 해보라니까 해볼게... [목표] http 및 상태 확인 방화벽 규칙 만들기 두 개의 인스턴스 템플릿 구성 관리형 인스턴스 그룹 2개 만들기 IPv4 및 IPv6을 사용하여 http 로드밸런서 구성 http 로드밸런서 스트레스 테스트 http 로드밸런서에 대한 액세스를 제한하기 위해 ip 주소 거부 ..

VPC 네트워크 - 액세스 제어 개 요 두개의 nginx 웹 서버를 만들고 태그가 지정된 방화벽 규칙을 사용하여 웹 서버에 대한 외부 http 액세스를 제어한다. 그런다음 iam 역할 및 서비스 계정을 탐색한다. 목 표 nginx 웹 서버 생성 태그가 지정된 방화벽 규칙 만들기 iam 역할이 있는 서비스 게정 생성 네트워크 관리자 및 보안 관리자 역할에 대한 권한탐색 1. 웹 서버 생성 [블루/그린서버 생성] vm instance 생성 - name : blue - zone : us-central1-a - networking * networkk tags : web-server - name : green - zone : us-central1-a [nginx 설치 및 시작 페이지 사용자 지정] blue ssh..

[PCK] Configure Secure RDP using a Windows Bastion Host(미완)

[PCK] Configure Secure RDP using a Windows Bastion Host(미완)

Configure Secure RDP using a Windows Bastion Host [미완성] Windows 배스천 호스트를 사용하여 보안 RDP 구성 * Bastion Host - 침입차단 sw가 설치되어 내부-외부네트워크 사이에서 일종의 게이트 역할을 수행하는 호스트 - 네트워크 보안 상 가장 중요한 방화벽 호스트 - 이 외에도 screened host, dual homed host, screened subnet, multi homed host 등이 있음 - 참고 https://blog.naver.com/pentamkt/221034903499 ** 참고 : https://www.youtube.com/watch?v=jfIxkg4RiS8 목표 1. 보안 프로덕션 windows 서비스를 호스팅할 새 ..

[Qwiklabs]Networking in Google Cloud _User Authentication: Identity-Aware Proxy

[Qwiklabs]Networking in Google Cloud _User Authentication: Identity-Aware Proxy

개 요 IAP(Identity-Aware Proxy)를 사용하여 애플리케이션에 대한 액세스를 제한하고 애플리케이션에 사용자 id 정보를 제공하는 방법을 살펴본다. python 이용 간단한 app engine 앱 작성 및 배포 앱에 대한 액세스를 제한하기 위해 IAP 활성화 및 비활성화 방법 IAP에서 앱으로 사용자 ID 정보를 가져오는 방법 스푸핑으로부터 보호하기 위해 IAP의 정보를 암호화 방식으로 확인하는 방법 IAP(Identity-Aware Proxy)란? IAP(Identity-Aware Proxy)는 애플리케이션으로 전송된 웹 요청을 가로채고 google id 서비스를 사용하여 요청하는 사용자를 인증하며 승인한 사용자가 보낸 요청인 경우에만 요청을 통과하도록 허용해주는 google cloud ..

VPC 네트워킹 기초 vpc network > routes > default route(0.0.0.0/0) 확인 vpc network > firewall > default-allow-* 4가지 확인 1. 기본 네트워크 삭제 vpc network 삭제 후 route 확인 > route 확인하면 아무것도 없음! * vpc 네트워크가 없으면 route도 없음 2. vm 인스턴스 생성 시도 는 안됨 3. 방화벽 규칙으로 자동모드 vpc 네트워크 만들기 ** 참고 : https://jiniers.tistory.com/5 - 자동모드 네트워크 만들기 4. vm 인스턴스만들기 4-1. name = mynet-us-vm zone = us-central1-c machine-type=n1-standard-1 > shell..